Warum ist Einstein Copilot für Tableau vertrauenswürdig?

Möchten Sie mit Einstein Copilot die analytische Kapazität Ihres Unternehmens erweitern? Mit diesem leistungsstarken Tool können Sie schneller als je zuvor Ihre Daten erkunden, Erkenntnisse gewinnen und Visualisierungen erstellen. Bevor wir uns ausführlich mit Einstein Copilot beschäftigen, wollen wir zeigen, in welcher Weise es den zentralen Wert von Tableau und Salesforce verkörpert: Vertrauen. Wir wollen darstellen, wie Einstein Trust Layer Ihre Daten schützt, die Genauigkeit der Ergebnisse optimiert und Audits ermöglicht. Ich werde außerdem auf die gängigsten Fragen und Anliegen unserer Kunden eingehen.

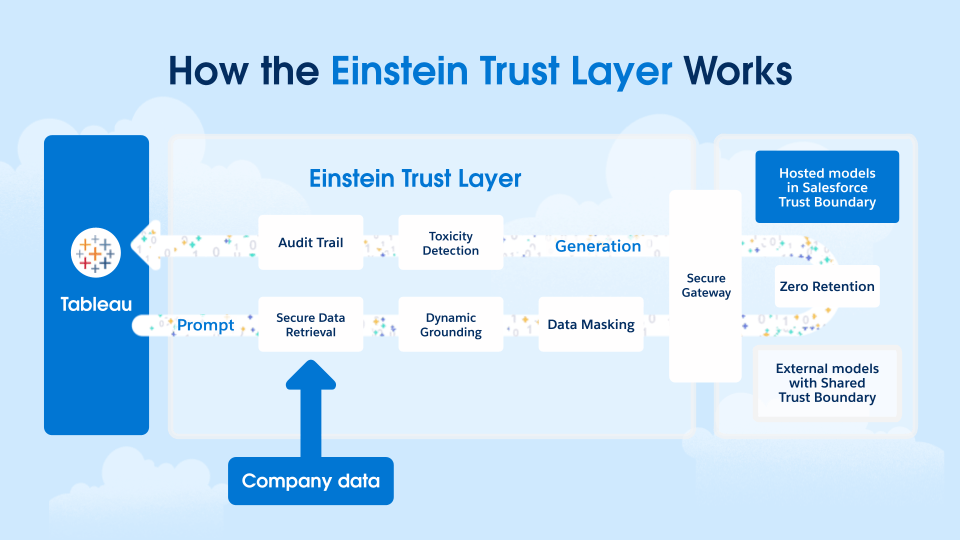

Was ist der Einstein Trust Layer?

Der Einstein Trust Layer ist eine sichere KI-Architektur, die in die Salesforce-Plattform integriert ist. Er besteht aus einer Reihe von Vereinbarungen, aus Sicherheitstechnologie sowie aus Daten- und Datenschutzkontrollen, die für die Sicherheit Ihrer Daten sorgen, wenn Sie generative KI-Lösungen erkunden. Einstein Copilot für Tableau und andere Tableau AI-Features basieren auf dem Einstein Trust Layer und nutzen alle seine Funktionen in Bezug auf Sicherheit, Governance und Vertrauen.

Wer hat Zugang zu meinen Daten?

Die häufigste Frage unserer Kunden zu Einstein Copilot für Tableau lautet: „Wer hat Zugriff auf die Daten meines Unternehmens und was wird mit meinen Daten gemacht?“. Zur Beantwortung dieser Frage wollen wir als Erstes darstellen, durch welche Funktionen sich der Einstein Trust Layer auszeichnet.

Die vertraglichen Vereinbarungen mit unseren externen LLM-Anbietern (Open AI und Azure Open AI) beinhalten eine Richtlinie zum Verzicht auf jegliche Datenaufbewahrung. Das heißt, der Einstein Trust Layer gewährleistet, dass an LLMs gesendete Daten dort nicht gespeichert werden. Nachdem Prompt und Antwort vom LLM verarbeitet wurden, „vergisst“ es diese sofort. Das bedeutet auch, dass von den Daten Ihres Unternehmens niemand außerhalb Ihres Unternehmens profitiert. Sie werden also auch nicht zum Trainieren von Modellen genutzt – weder innerhalb noch außerhalb der Vertrauensgrenzen von Tableau und Salesforce.

Die von Ihren Benutzern generierten Prompts und die Antworten, die Sie von Einstein Copilot für Tableau darauf erhalten, sind ausschließlich Ihr Eigentum. Für LLMs sind sie nicht mehr verfügbar. Jeder Kunde von Einstein Copilot für Tableau erhält auch eine eigene Data Cloud-Instanz, in der Prompts und Antworten sicher gespeichert sind. Diese Daten stehen über den Audit Trail des Trust Layer zu Audits durch Ihre Teams für Informationssicherheit zur Verfügung.

Für die Daten in Tableau Cloud und bevor sie den Einstein Trust Layer erreichen, berücksichtigt Einstein Copilot für Tableau alle Berechtigungen, die Sicherheit auf Zeilenebene (also Benutzerfilter) sowie die Datenrichtlinien für virtuelle Verbindungen. Das bedeutet: Wenn ein Benutzer keinen Zugriff auf bestimmte Daten auf Ihrer Tableau Cloud-Site hat, kann er sie auch nicht mit Einstein Copilot nutzen. Nur Personen in Ihrem Unternehmen, die explizit Zugriff auf bestimmte Daten haben sollen, können diese Daten aufrufen und verwenden – unabhängig davon, ob Einstein Copilot für Tableau genutzt wird.

Welche Daten werden über meine Tableau Cloud-Site hinaus gesendet?

Eine erste Antwort bietet das Architekturdiagramm oben. Außerdem wird darauf bei der ausführlichen Darstellung der Funktionsweise von Einstein Copilot eingegangen. Einstein Copilot für Tableau berücksichtigt nur den Kontext der Datenquelle in einer Sitzung der Webdokumenterstellung. Als Erstes scannt Einstein Copilot die Tableau-Datenquellen, mit denen die Arbeitsmappe verbunden ist, und erstellt einen zusammenfassenden Kontext der Datenquelle. Dieser enthält Folgendes:

- Feldnamen und Beschreibungen

- Felddatentypen (Zeichenfolge, numerisch, Datum/Uhrzeit usw.)

- Bei nicht numerischen Feldern: eindeutige Werte in einem Feld mit bis zu 1.000 eindeutigen Werten (Hinweis: Nicht numerische Felder mit einer Kardinalität > 1.000 werden ignoriert)

Das Scannen und Zusammenfassen erfolgt komplett innerhalb der Grenzen Ihrer Tableau-Site. Die Zusammenfassung wird dann an unseren externen LLM-Anbieter gesendet, der die Feldnamen sowie eindeutige Werte in nicht numerischen Feldern vektorisiert. Das Vektorisieren von Feldern und eindeutigen Werten hat eine zentrale Bedeutung, da es Einstein Copilot für Tableau ermöglicht, umgangssprachliche Begriffe, Abkürzungen und Synonyme in Benutzer-Prompts zu verstehen. Angenommen, Sie verfügen über einen Datensatz mit den Feldern [Prognose_Umsatz] und [Produktlinie], wobei darin ein Wert „Sportausrüstung“ lautet. Durch die Vektorisierung ist Einstein Copilot für Tableau in der Lage, eine Benutzerabfrage wie z. B. „Wie viele Sportprodukte werden wir voraussichtlich im Mai verkaufen?“ in eine Visualisierung zu übersetzen, die [Prognose_Umsatz] für [Produktlinie] = „Sportausrüstung“ im Monat Mai anzeigt.

Aufgrund unserer für die externen LLM-Anbieter geltenden Richtlinien zum Verzicht auf jegliche Datenaufbewahrung wird der zusammenfassende Kontext nach der Visualisierung sofort „vergessen“.

PII-Daten

Dies ist nun die Gelegenheit, sich den personenbezogenen Daten (Personally Identifiable Information, PII) zu widmen. Standardmäßig aktiviert Einstein Copilot für Tableau das Feature Datenmaskierung des Einstein Trust Layer. Dabei werden mithilfe von Mustervergleich und Machine-Learning-Techniken die PII-Daten in den Prompts identifiziert und PII-Zeichen – basierend auf deren Bedeutung – durch Platzhaltertext ersetzt, bevor sie an die Large Language Models (LLMs) gesendet werden. Durch die Verwendung von Platzhaltertext anstelle von generischen Symbolen kann das LLM den Kontext des Prompt berücksichtigen und so relevantere Ergebnisse generieren. Einstein Trust Layer demaskiert dann die Antwort, wenn sie an den Benutzer zurückgegeben wird. Sie verfügt damit über die relevanten Daten. Einstein Copilot für Tableau macht die folgenden Daten unkenntlich:

- Name

- E-Mail-Adresse

- Telefonnummer

- US-SSN

- Firmenname

- IBAN-Code

- US-ITIN

- Reisepassnummer

- US-Führerschein

Bei den Tests werden zwar unser Muster und ML-basierte Modelle zur Datenermittlung angewendet, allerdings kann kein Modell eine 100-prozentige Genauigkeit garantieren. Außerdem kann bei Anwendungsfällen, die sich über mehrere Regionen und Länder erstrecken, die Fähigkeit zur Ermittlung von PII-Daten beeinträchtigt sein. Da die Schaffung von Vertrauen für uns Priorität hat, streben wir eine fortlaufende Evaluierung und Verfeinerung unserer Modelle an.

Das Unkenntlichmachen von PII-Daten kann konfiguriert werden, nämlich in den Einstellungen des Einstein Trust Layer in Ihrer Salesforce-Organisation, die im Rahmen von Einstein Copilot für Tableau bereitgestellt wird.

Welchen Weg nehmen meine Daten?

Jeder Aufruf von Einstein Copilot für Tableau an das LLM führt dazu, dass Daten von Ihrer Tableau-Site an das LLM übertragen werden – mit einem „Zwischenstopp“ bei Ihrer Salesforce-Organisation, die im Rahmen von Einstein Copilot für Tableau bereitgestellt wird. Was die Datenherkunft betrifft, wird die Region, in der Ihre Tableau Cloud-Site gehostet wird, bei der Bereitstellung der Site eingerichtet. In gleicher Weise können Sie bei der Bereitstellung die Region für Ihre Salesforce-Organisation so auswählen, dass diese mit jener Ihrer Tableau-Site identisch ist. Aktuell wird das OpenAI-LLM, das wir nutzen, in den USA gehostet. Allerdings werden wir im Laufe des Jahres Azure OpenAI als weitere LLM-Option anbieten. Mit der Azure-Option können Sie die Region für das LLM festlegen und so die Datenherkunft vollständig kontrollieren. Beachten Sie, dass nicht alle Regionen unterstützt werden. Wenden Sie sich deshalb bitte an Ihren Tableau Solutions Engineer, um mit ihm Ihre Anforderungen an die Datenherkunft zu besprechen und Lösungen dafür zu finden.

Was macht die Ergebnisse von Einstein Copilot für Tableau vertrauenswürdig?

Vertrauen entsteht nicht nur dadurch, dass die Daten sicher sind. Vertrauen bedeutet auch, dass Sie sich darauf verlassen können, dass die Ergebnisse von Einstein Copilot für Tableau präzise und zuverlässig sind. Wir nutzen einerseits Techniken und Kontrollen, um die Genauigkeit zu maximieren und möglichen Schaden zu minimieren. Andererseits können wir wie bei allen Ergebnissen von generativer KI keine 100-prozentige Genauigkeit garantieren.

Zuverlässige, sichere Ergebnisse

Einstein Copilot für Tableau nutzt das Toxicity Confidence Scoring des Einstein Trust Layer, um schädliche LLM-Eingaben und -Antworten zu ermitteln. Im Hintergrund nutzt der Trust Layer eine hybride Lösung, die einen regelbasierten Schimpfwortfilter mit einem von Salesforce Research entwickelten KI-Modell kombiniert. Das KI-Modell ist ein Transformatormodell (auf Flan-T5-Basis), das mit 2,3 Millionen Prompts aus 7 Datensätzen trainiert wurde, die die Rechtsabteilung von Salesforce freigegeben hat. Dieses Modell bietet Bewertungen für sieben verschiedene Kategorien schädlicher Prompts und Antworten, darunter Toxizität (z. B. unhöfliche, respektlose Kommentare), Gewalt und vulgäre Ausdrücke. Einstein Copilot für Tableau filtert mithilfe von Benchmarks, die vom Einstein-Team iterativ entwickelt wurden, schädliche Inhalte und gibt an die Benutzer eine entsprechende Warnung aus. Schädliche Inhalte werden zusammen mit den zugehörigen Confidence Scores gespeichert und können von Ihren Teams über den Audit Trail geprüft werden.

Genaue Ergebnisse

Wir messen und bewerten die Genauigkeit von Einstein Copilot für Tableau für jede Version mithilfe eines Testdatensatzes mit über 1.500 Werten (Abfrage, Visualisierung) und Paaren (Abfrage, Tableau-Berechnung) aus unserer internen Tableau-Nutzung (auch wir verwenden unser Produkt in großem Umfang). Wir haben eine Reihe von Metriken definiert, um die Relevanz und Genauigkeit LLM-generierter Visualisierungen im Vergleich zu von Menschen erstellten zu bewerten. Diese repräsentieren die unterschiedlichen Möglichkeiten, mit denen Benutzer analytische Fragen an ECT stellen können. Beispiele:

- Kanonische Genauigkeit: Misst, wie genau die generierte begriffliche Spezifikation der erwarteten begrifflichen Spezifikation entspricht.

- Genauigkeit der semantischen Übereinstimmung: Misst, wie genau die generierte begriffliche Spezifikation der erwarteten begrifflichen Spezifikation in Bezug auf die Platzhalterübereinstimmung entspricht. Platzhalterübereinstimmungen sind aufgrund der vielfältigen Möglichkeiten erforderlich, wie eine Visualisierung dargestellt werden kann. Beispiele: Relative Datumsfilter im Vergleich zu Datumsbereichsfiltern, mehrere Datumsfelder zur Darstellung von Trendliniendiagrammen usw.

- Recall: % der erwarteten Felder, die korrekt durch Suchabfragen zurückgegeben und vom LLM ausgewählt werden

Um diese hohe Genauigkeit zu erreichen, verwenden wir dynamische Kontexte (auch als „Retrieval Augmented Generation“ oder „RAG“ bezeichnet). Dazu weisen wir das LLM an, die folgenden Informationen in unseren Prompts zu berücksichtigen:

- Die Metadaten, die Ihre Datenquelle beschreiben (zur Charakterisierung dieser Metadaten siehe Welche Daten werden über meine Tableau Cloud-Site hinaus gesendet?). Diese vermitteln dem LLM den Kontext unserer Datenquelle und verhindern das Halluzinieren von Feldern, die in Ihrem Datensatz nicht vorhanden sind.

- Historischer Chatverlauf der Sitzung. Dies ermöglicht Einstein Copilot für Tableau, Demonstrativpronomen (wie „diese“, „jene“, „dieser“, „jener“ usw.) zu verstehen, um auf früher in der Chatsitzung genannte Begriffe/Konzepte zu rekurrieren.

- Die aktuelle Visualisierung für Ihr Arbeitsblatt. Dies vermittelt dem LLM den Kontext Ihrer aktuellen Visualisierung, damit Änderungen daran exakt durchgeführt werden können.

Zusätzlich zum dynamischen Kontext passen wir iterativ an, wie Einstein Copilot für Tableau mit Mehrdeutigkeit verfährt. Ein Beispiel ist eine einfache Abfrage wie „Zeige mir den Umsatz in den letzten 6 Monaten nach Produkt“. Wenn es mehrere Felder vom Typ „Datum/Uhrzeit“ gibt, ist nicht eindeutig, worauf sich die Phrase „in den letzten 6 Monaten“ bezieht. Aktuell stellt Einstein Copilot für Tableau dafür eine Folgefrage an den Benutzer, in der es die wahrscheinlichsten Optionen für das Feld „Datum/Uhrzeit“ zur Darstellung der Visualisierung anbietet.

Wie wird das Vertrauen in Einstein Copilot für Tableau weiter gefördert?

Die Schaffung von Vertrauen ist kein einmaliger Vorgang. Unsere Teams für Einstein Copilot für Tableau und den Einstein Trust Layer verbessern vor dem Hintergrund von Kundenfeedback iterativ deren Features, um das Vertrauen in uns weiter zu gewährleisten. Beispielsweise entwickeln wir aktuell eine BYO-LLM-Lösung für Kunden, bei der externe LLM-Anbieter keine Rolle spielen. Außerdem verbessern wir die Fähigkeit von Einstein Copilot für Tableau, Mehrdeutigkeiten aufzulösen, etwa durch Erlernen, welche Kennzahlen und Dimensionen in der Regel gemeinsam verwendet werden. Wir führen auch häufig Tests neuer und verbesserter Prompts durch. Dabei bewerten wir diese anhand unseres Benchmark-Datensatzes und können so leistungsstarke wie genaue Prompts bereitstellen.

Bei Tableau und Salesforce ist uns bewusst, dass die Schaffung von Vertrauen weiterhin eine große Herausforderung darstellt. Vertrauen ist wichtig, damit Sie Ihre Betriebsgeheimnisse und Kundendaten der generativen KI anvertrauen und gleichzeitig deren Vorteile ausschöpfen können. Ich hoffe, dieser Blogpost konnte einige Ihrer drängendsten Fragen und Anliegen zu Einstein Copilot für Tableau beantworten. Wenn Sie weitere Fragen zu Einstein Copilot für Tableau oder zum Einstein Trust Layer haben, können Sie jederzeit hier einen Kommentar verfassen. Ich werde versuchen, auf alle Mitteilungen zu antworten. Alternativ steht Ihnen Ihr Vertriebsmitarbeiter bei Tableau zur Verfügung. Er kann Ihnen Fachexperten nennen, die Ihnen bei Ihrem jeweiligen Anliegen weiterhelfen.

Zugehörige Storys

Blog abonnieren

Rufen Sie die neuesten Tableau-Updates in Ihrem Posteingang ab.